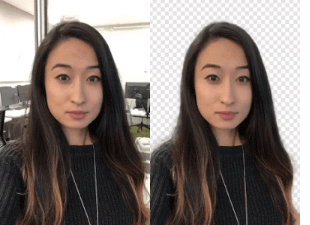

宣布适用于手机的背景交换技术

视频创作者:想交换背景吗?自己敲门。Google研究人员一直在研究一种方法,让您可以使用神经网络交换视频背景-无需绿屏。它的滚动出来的YouTube故事移动以有限的方式,说TechCrunch的。Android Headlines的John Anon表示,YouTube创作者可以更改背景以创建更具吸引力的视频。

Google Research的软件工程师Valentin Bazarevsky和Andrei Tkachenka宣布了这一消息,标题为“移动实时视频分段”。

视频内容创建者知道,可以将场景的背景与被视为两个不同层的背景分开。进行此操作是为了获得心情,或者插入一个有趣的位置或增强消息的影响力。

谷歌研究网站上的两者说,这项操作“是一项耗时的手动过程(例如,艺术家对每一帧进行旋转摄影),或者需要一个带有绿屏的工作室环境来进行实时背景去除(这种技术称为色度技术)。键控”。

翻译:《数字趋势》杂志的希拉里·格里戈尼斯(Hillary Grigonis)说:“替换视频背景通常需要使用先进的桌面软件和大量的空闲时间,或者是配备绿色屏幕的成熟工作室。”

现在,两者宣布了一项新技术,它将在手机上运行。

他们的技术将使创作者无需专门的设备即可替换和修改背景。

他们称这是YouTube专门为YouTube创作者设计的新型轻量级视频格式。

他们在3月1日发布了“通过将这项技术集成到故事中,对YouTube应用进行精确,实时的设备上移动视频细分”的公告。

他们是如何做到的?阿农说:“这一切的关键在于机器学习。”

Bazarevsky和Tkachenka说,他们利用“机器学习使用卷积神经网络解决语义分割任务”。

翻译:“谷歌正在开发一种可以通过智能手机摄像头实时工作的人工智能替代品,”格里戈尼斯写道。

两位工程师描述了适用于手机的架构和培训过程。他们牢记“移动解决方案应该是轻量级的,并且其运行速度应比现有的最新照片分割模型至少快10-30倍”。

至于数据集,它们“注释了成千上万张图像”。这些捕获了各种各样的前景姿势和背景设置。

Grigonis说:“利用该数据集,该小组训练了该程序以将背景与前景分开。”

TechCrunch的Devin Coldewey表示:“网络学会了选择头部和肩膀的共同特征,并且进行了一系列优化,降低了处理数据所需的数据量。”

Digital Trends解释了它的工作原理:“一旦软件在第一张图像上遮蔽了背景,程序就会使用相同的遮罩来预测下一帧的背景。当下一帧与第一帧相比只有很小的调整时...程序将对遮罩进行少量调整。当下一帧与上一帧有很大不同时...软件将完全放弃该遮罩预测并创建一个新的遮罩。”

正如他们在Google Research博客上所说的那样,他们工作的最终结果是“我们的网络在移动设备上的运行速度非常快,在iPhone 7上达到了100+ FPS,在Pixel 2上达到了40+ FPS(实现了94.8%的IOU我们的验证数据集),在YouTube故事中提供了各种流畅运行和自适应效果。”

下一步是什么?

它是限量版。“我们的近期目标是利用YouTube故事中有限的推出来测试我们在第一组效果上的技术。随着我们将细分技术改进和扩展到更多标签,我们计划将其集成到Google的更广泛的增强现实服务中。”

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

试驾极狐阿尔法S(ARCFOX αS)是一次令人印象深刻的体验。从咨询开始,品牌的专业客服迅速回应了我的疑问,...浏览全文>>

-

如果您想预约哈弗猛龙的试驾体验,可以按照以下步骤快速在4S店完成预约:首先,您可以通过哈弗汽车的官方网站...浏览全文>>

-

如果您想体验零跑汽车的试驾服务,可以通过以下步骤在4S店快速预约:首先,访问零跑汽车的官方网站或通过其官...浏览全文>>

-

试驾奔驰迈巴赫S级的预约流程简单清晰,以下是具体步骤:首先,访问奔驰官方网站或联系当地授权经销商。在网站...浏览全文>>

-

纳米01试驾流程通常包括以下几个步骤:第一步:预约试驾用户可以通过品牌官网、4S店或电话预约试驾。提前预约...浏览全文>>

-

奔腾B70是一款集时尚设计与卓越性能于一身的中型轿车,近期有幸对其进行了一次深度试驾。这款车型不仅外观大气...浏览全文>>

-

想要快速预约福特蒙迪欧的试驾体验驾驶乐趣?以下是一些简单步骤帮助您轻松完成:首先,访问福特官网或通过福...浏览全文>>

-

大众试驾,轻松搞定试驾想要深入了解一款车的性能与驾驶感受?试驾是最佳选择!无论是追求操控感的运动型轿车...浏览全文>>

-

试驾现代胜达时,您需要满足一些基本条件以确保安全和顺利的体验。首先,您必须持有有效的驾驶证,并且驾龄通...浏览全文>>

-

小鹏G7是一款备受关注的智能电动车,对于新手来说,试驾前需要了解一些关键步骤和注意事项,确保安全且充分体...浏览全文>>

- 哈弗猛龙预约试驾,如何在4S店快速预约?

- 零跑汽车试驾,如何在4S店快速预约?

- 江淮iEV7试驾预约预约流程

- 试驾MG4 EV全攻略

- 奥迪SQ5 Sportback预约试驾,线上+线下操作指南

- 全顺试驾预约,一键搞定,开启豪华驾驶之旅

- 魏牌预约试驾全攻略

- 试驾零跑汽车零跑C01,畅享豪华驾乘,体验卓越性能

- 试驾哈弗H6操作指南

- 零跑T03试驾,畅享豪华驾乘,体验卓越性能

- 菱势汽车预约试驾,轻松搞定试驾流程

- MINI试驾,线上+线下操作指南

- 试驾沃尔沃XC60,从预约到试驾的完美旅程

- 试驾QQ多米,畅享豪华驾乘,体验卓越性能

- 试驾丰田汉兰达,一键搞定,开启豪华驾驶之旅

- 力帆预约试驾,一键搞定,开启豪华驾驶之旅

- 阿维塔12预约试驾,4S店体验全攻略

- 试驾江铃E路顺V6,简单几步,开启完美试驾之旅

- 灵悉L试驾预约,如何享受4S店的专业服务?

- 极氪7X试驾,如何享受4S店的专业服务?